2 Datos de satélite y sus análisis

2.1 Plataformas y sensores satelitales

Además de las fotografías aéreas, las imágenes de satélite son otra fuente importante de datos de Observación de la Tierra (OT) que hoy en día tienen un enorme valor estratégico en muchos ámbitos. Los sensores basados en satélites permiten registrar y analizar amplias zonas de la superficie terrestre a altas velocidades de repetición. Un número cada vez mayor de plataformas y sensores satelitales proporcionan datos para una amplia gama de aplicaciones, desde la “A”, como el uso agrícola (por ejemplo, la medición de la humedad del suelo), hasta la “Z” (‘T’ 😉), como el análisis de series de tiempo (por ejemplo, el seguimiento de la expansión urbana). En las últimas décadas hemos asistido a un uso cada vez mayor de los datos de imágenes satelitales, basado en servicios de bajo coste o gratuitos y actualizados. Y la innovación sigue avanzando a buen ritmo, sobre todo en lo que respecta al suministro de datos de alta resolución y fácil acceso.

2.1.1 Fundamentos de la teledetección

En teledetección, un dispositivo de registro de imágenes capturadas remotamente (normalmente denominado sensor) se monta en un sistema de registro (la plataforma o el satélite).

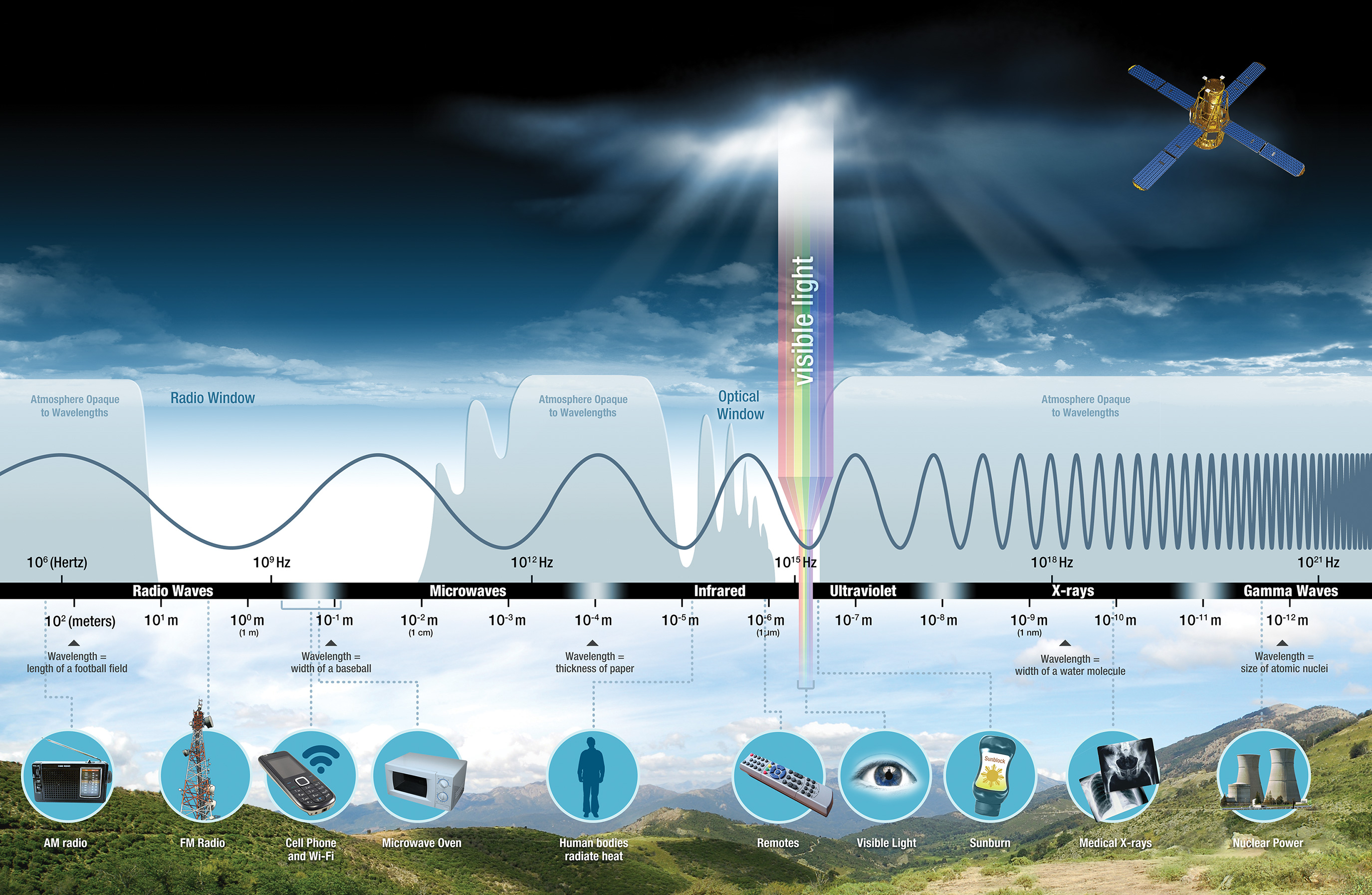

En la mayoría de las aplicaciones, los sensores de las plataformas de teledetección registran la radiación electromagnética, que se propaga como energía a través del espacio en forma de ondas electromagnéticas. El espectro electromagnético (EM) abarca desde los rayos gamma de onda extremadamente corta y los rayos X hasta las ondas de radio y más allá (véase la Figura 2.1). La luz visible sólo cubre un rango muy pequeño del espectro electromagnético (longitudes de onda entre 0,4 y 0,7 µm) que un ojo humano como “sensor remoto” es capaz de detectar.

Aunque la radiación solar entrante cubre una zona relativamente amplia del espectro electromagnético total, la atmósfera filtra determinadas gamas de frecuencias y nos protege así, por ejemplo, de los rayos cósmicos de alta energía (y potencialmente nocivos). Una parte de la radiación que entra hacia la superficie terrestre se absorbe, mientras que otra parte se refleja de nuevo. Qué longitudes de onda son “tragadas” por un objeto y cuáles son reflejadas, depende de las propiedades físicas de su superficie.

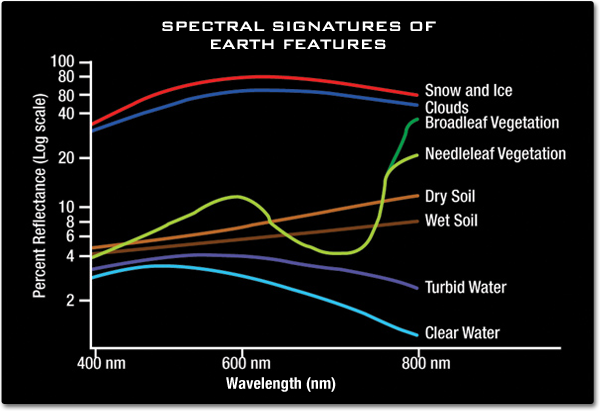

Cada tipo de material, cubierta terrestre, roca o masa de agua sólo refleja una parte muy específica del espectro electromagnético y, por tanto, tiene una firma espectral única (véase la Figura 2.2). La vegetación absorbe mucha luz azul y roja, mientras que refleja específicamente las longitudes de onda del infrarrojo cercano (NIR) del espectro electromagnético, por otra parte, el agua refleja las longitudes de onda del espectro azul, por citar sólo algunos ejemplos. Además, los sensores de teledetección pueden procesar algo más que la parte del espectro electromagnético visible para nuestros ojos. De este modo, se pueden obtener capas adicionales de información de la superficie de la Tierra, que si se utilizará solo nuestros ojos.

Los sensores de teledetección registran las firmas espectrales de los objetos de la superficie terrestre (= la radiación electromagnética reflejada). Al analizar los datos de teledetección, los objetos se identifican y clasifican en función de sus firmas espectrales características. En teledetección, los términos “bandas espectrales” y “canales espectrales” se utilizan como sinónimos: Mientras que banda espectral se utiliza para representar el número de capas de una imagen de satélite (como “Banda 1”, “Banda 2”, etc.), canales espectrales se utiliza para describir el color (o longitud de onda) que representa (Infrarrojo, Infrarrojo cercano, etc.). A modo de ejemplo, observe cómo el sensor Landsat 7 ETM+ registra el espectro electromagnético en ocho bandas (ver la Tabla 2.1 ).

| Banda | Canal | Longitud de Onda (\(\mu m\)) | Resolución (\(m\)) |

| 1 | Azul | 0.45-0.52 | 30 |

| 2 | Verde | 0.52-0.60 | 30 |

| 3 | Rojo | 0.63-0.69 | 30 |

| 4 | Infrarojo cercano (NIR) | 0.77-0.90 | 30 |

| 5 | Infrarojo de onda corta (SWIR) 1 | 1.55-1.75 | 30 |

| 6 | Termal | 10.40-12.50 | 60 (30) |

| 7 | Infrarojo de onda corta (SWIR) 2 | 2.09-2.35 | 30 |

| 8 | Pancromático | .52-.90 | 15 |

Una escena de imagen satelital suele constar de varios canales que se graban al mismo tiempo. En cada canal, la radiación reflejada o emitida por la superficie terrestre se convierte en valores digitales en un rango específico del espectro electromagnético. Así, es posible obtener nueva información combinando o editando los canales originales. Los canales se combinan asignando las intensidades registradas en cada banda de un sensor a uno de los colores de la gama visible del espectro (azul, verde, rojo) para mostrar la imagen en una pantalla. Cuando se utilizan las bandas correspondientes a los colores respectivos (es decir, la luz roja reflejada se muestra roja en la pantalla, la banda verde se muestra verde y la banda azul, azul), el resultado es una imagen en color verdadero. Sin embargo, y a menudo incluso más interesante para el análisis de datos de teledetección, son las longitudes de onda más allá del espectro visible de la luz. Por ejemplo, para detectar en color la vegetación activa (que refleja específicamente en el espectro del infrarrojo cercano, como ya hemos oído), la banda del infrarrojo cercano se muestra en rojo en una imagen en falso color (véase la Figura 2.3).

2.1.2 Resolución

En teledetección, la resolución de los datos de imagen tiene una importancia crucial.

Podemos distinguir cuatro tipos diferentes de resolución que deben tenerse en cuenta en las aplicaciones de teledetección. Por ello, los explicaremos con más detalle en este capítulo:

- La resolución espectral viene determinada por la gama de longitudes de onda del espectro electromagnético que puede registrar un sensor.

- La resolución espacial se refiere al tamaño en píxeles de una escena de imagen y viene determinada por las propiedades geométricas del sistema de imagen.

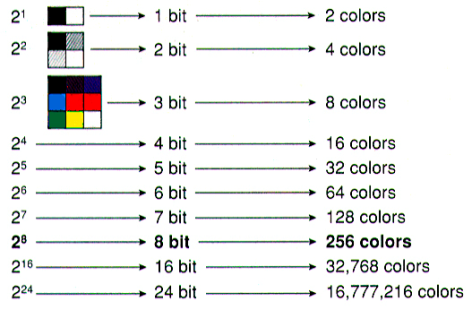

- La resolución radiométrica se refiere al número de bits que distinguen los valores de brillo de una imagen.

- La Resolución Temporal está relacionada con la cobertura repetitiva del terreno por el sistema de teledetección en diferentes periodos de tiempo.

2.1.2.1 Resolución espectral

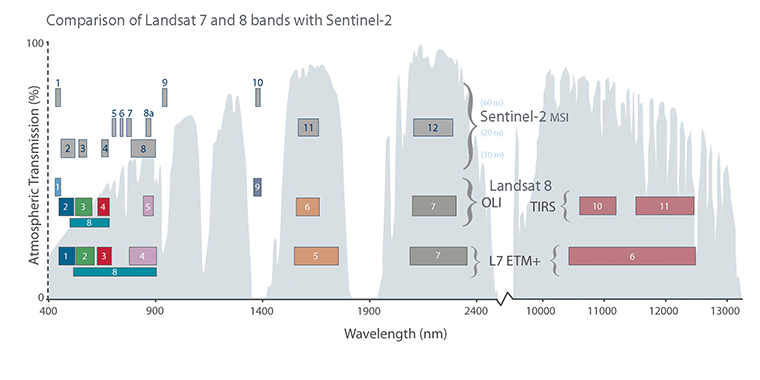

La resolución espectral define el número de canales (o bandas), así como el rango de longitudes de onda del espectro electromagnético en el que un sensor puede registrar la radiación. Por ejemplo, Sentinel-2 tiene 13 bandas que cubren longitudes de onda entre 15 nm (banda 5) y 180 nm (banda 12).

Una imagen tiene una resolución espectral gruesa, cuando un sensor graba la imagen en sólo unas pocas bandas que cubren una amplia gama del espectro electromagnético. Mientras que el registro de una imagen con un sensor que opera muchas bandas que cubren sólo un estrecho rango espectral, da como resultado una resolución espectral fina de la imagen. En este esquema, se suele distinguir entre sistemas de teledetección pancromáticos (en los que toda la luz visible se registra en un único canal espectral), sistemas multiespectrales (entre 3 y aproximadamente 10 canales espectrales) y sistemas hiperespectrales (entre 10 y varios cientos de canales espectrales).

Por ejemplo, las clases de cubierta terrestre pueden distinguirse comparando su reflexión en las distintas gamas espectrales. Una clasificación gruesa de la cubierta terrestre, como la del agua y la vegetación, puede hacerse fácilmente utilizando una amplia gama de longitudes de onda (por ejemplo, bandas de la luz visible y de la radiación infrarroja cercana). Si lo que se pretende es una clasificación más detallada, como la de los distintos tipos de rocas, hay que utilizar un sensor con mayor resolución espectral que permita analizar una gama más fina de longitudes de onda.

2.1.2.2 Resolución espacial

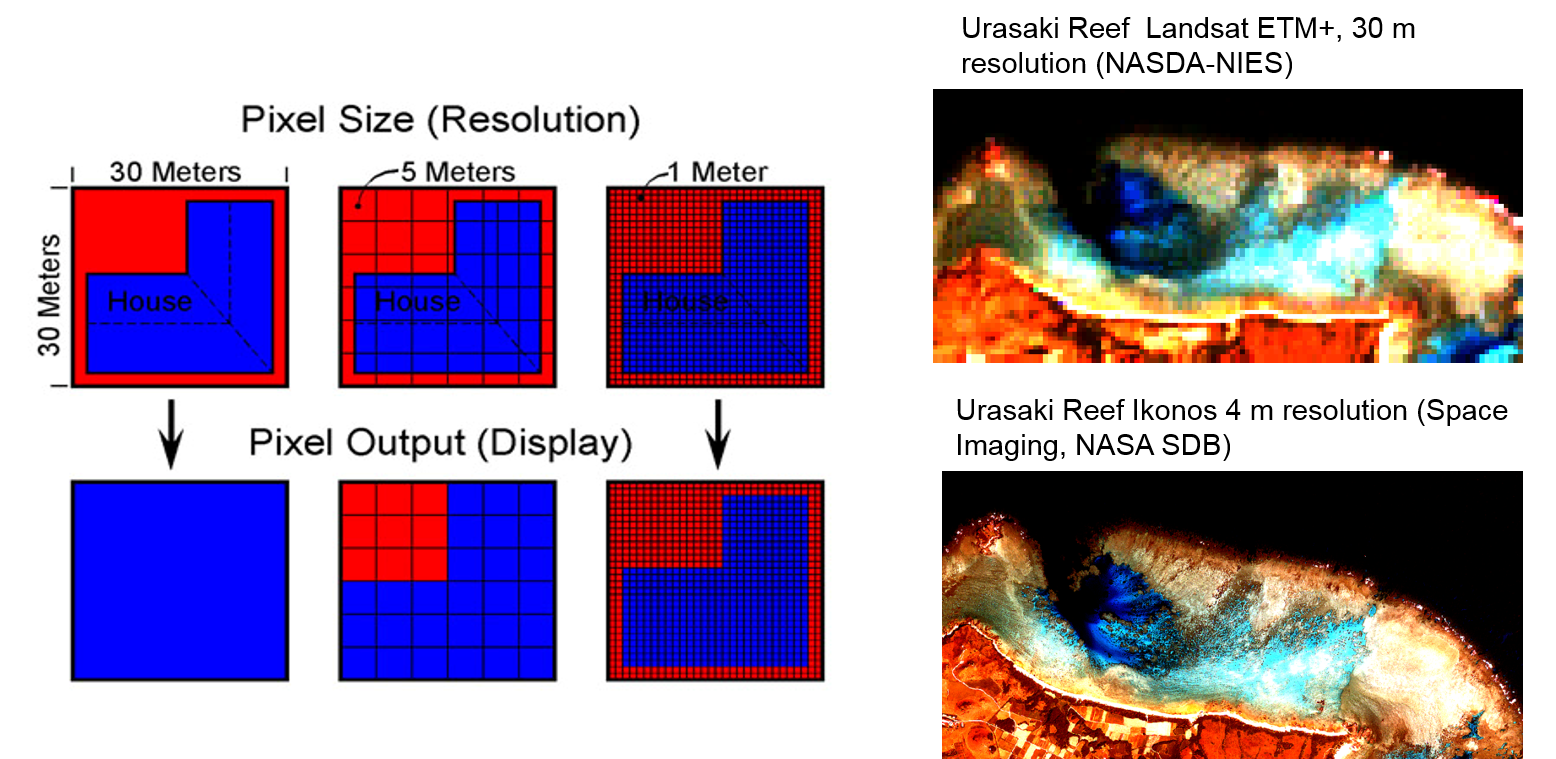

La resolución espacial (o resolución terrestre) es una medida del área unitaria más pequeña en el nadir de la geometría de la imagen, cuyo valor espectral o valor de brillo es registrado por un sensor. Se aplica lo siguiente: cuanto más fina (más alta) sea la resolución, menor será el número correspondiente de la resolución espacial. Una resolución espacial de 30 x 30 metros es menor (“más pixelada”) que una de 5 x 5 metros o 1 x 1 metros (véase la Figura 2.4).

Desde un punto de vista físico y técnico, la resolución espacial y espectral no pueden tratarse de forma totalmente aislada: Si la zona del suelo que registra un sensor es muy pequeña (alta resolución espacial), sólo puede emitir poca energía electromagnética. Si, además, restringimos el análisis a un pequeño rango de longitudes de onda, la cantidad de energía restante puede llegar a ser tan pequeña que el sensor ya no pueda registrarla. Aunque los sensores son cada vez más sensibles y capaces de trabajar con menos energía reflejada, la alta resolución espacial sigue produciéndose a expensas de la resolución espectral (y viceversa) (véase la Figura 2.5).

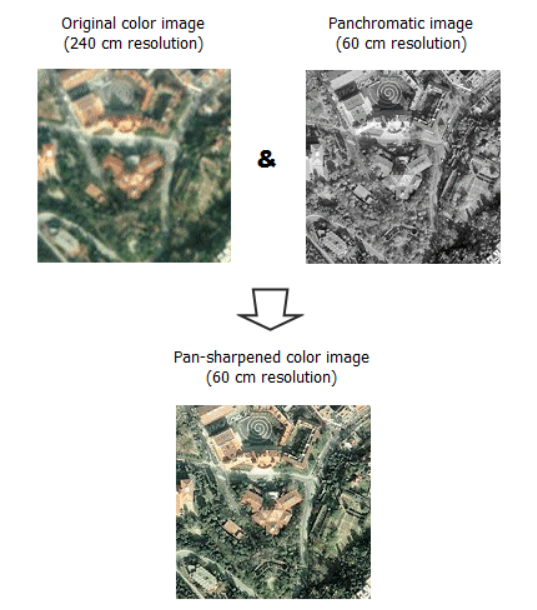

Por ello, muchas plataformas de satélites disponen de un canal pancromático adicional que cubre una amplia gama del espectro electromagnético (por ejemplo, toda la luz visible) y, por tanto, proporciona imágenes de alta resolución espacial. El proceso de enfoque panorámico (que explicaremos más adelante) aprovecha este canal adicional.

2.1.2.3 Resolución radiométrica

La resolución radiométrica se refiere a la capacidad de un sensor para diferenciar los valores de brillo de un píxel de la imagen y se mide en bits (dígitos binarios). Por ejemplo, la resolución radiométrica del sensor Landsat MSS (Multispectral Scanner System) solía ser de sólo 7 bits, lo que corresponde a 128 valores de gris (por canal). Las plataformas de satélite más recientes, como Landsat 8 TIRS y Sentinel-2, ofrecen resoluciones radiométricas significativamente más altas, de hasta 12 bits (4096 valores de gris). Aunque una mayor resolución radiométrica permite un análisis más preciso de una escena de imagen, el volumen de datos también aumenta considerablemente, y hay que disponer de espacio de almacenamiento adicional para procesar cada píxel de cada banda (véase la Figura 2.6).

2.1.2.4 Resolución temporal

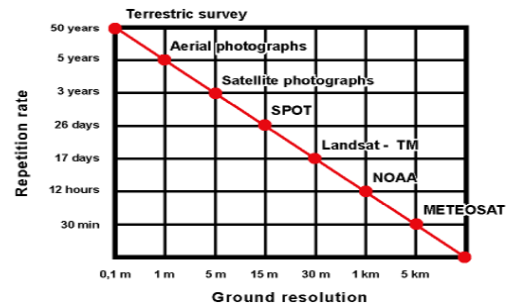

La resolución temporal (tasa de repetición o tiempo de revisita) es el intervalo de tiempo entre dos vuelos idénticos de una plataforma de satélite sobre la misma zona cuando se registra una imagen. Viene determinada por la altitud y la órbita del satélite, así como por las características de sus sensores (por ejemplo, el ángulo de visión). Los índices de repetición elevados son importantes para las aplicaciones que requieren una observación continua y puntual de los procesos que tienen lugar en la superficie terrestre (como las inundaciones). Por ejemplo, Sentinel-2 pasa sobre el mismo lugar de la Tierra cada cinco días. Algunos satélites comerciales pueden ajustar los registros ópticos de sus sensores a petición de los usuarios, de forma que una zona puede incluso registrarse con frecuencias más altas (por ejemplo, diariamente) (véase la Figura 2.7).

Eche un vistazo a este sitio web, que compara dos imágenes de satélite de diferentes años y los cambios en los patrones de urbanización a lo largo del tiempo.

2.1.3 Sistemas de detección pasivos y activos

Podemos distinguir dos tipos básicos de sensores de teledetección, según el tipo de radiación que procesan: sensores pasivos y activos.

Los sensores pasivos suelen recoger datos solo durante el día, ya que registran la radiación de la energía solar que se refleja en la superficie terrestre. Por lo tanto, la fuente de radiación utilizada en los sensores pasivos no es el propio sensor, sino una fuente externa de energía (principalmente el sol). En el capítulo siguiente explicaremos los sensores pasivos más importantes utilizados en teledetección.

Los sensores activos envían impulsos de energía artificial a un objetivo (la superficie terrestre) y procesan la energía reflejada. Dos ejemplos de sensores activos son el Light Detection and RAnging (LiDAR) y el RAdio Detection And Ranging (RADAR). Como ya sabemos, los sistemas LiDAR tienen un sensor activo que emite un pulso de luz láser a una longitud de onda y frecuencia conocidas. Este haz de luz incide en la superficie terrestre y se refleja en el sensor, que registra el tiempo que tarda en volver el haz. La teledetección con RADAR se explica con más detalle al final de esta lección.

2.1.4 Sensores y plataformas satelitales

Para empezar, eche un vistazo a este resumen de los satélites más importantes que actualmente orbitan la Tierra o lo hacían en el pasado. De todas las plataformas satelitales, en particular los satélites meteorológicos, como GOES o los satélites METEOSAT, se han hecho populares entre el público en general, ya que sus imágenes forman parte de las previsiones meteorológicas cotidianas (aunque la previsión meteorológica es sólo una parte de su trabajo).

A partir de 2023, los satélites METEOSAT de tercera generación proporcionarán datos de imágenes de Europa y África cada 10 minutos en 16 canales espectrales con una resolución de 500 a 2000 m (según el canal y el modo de funcionamiento). En el llamado modo de barrido rápido, Europa se barre cada 2,5 minutos con una mayor resolución geométrica. La serie METEOSAT también podrá detectar tormentas y relámpagos locales. Menos conocidos, pero no menos importantes, especialmente para los climatólogos, son otros sistemas satelitales que operan en órbitas más bajas cerca de los polos, como los satélites de la serie NOAA.

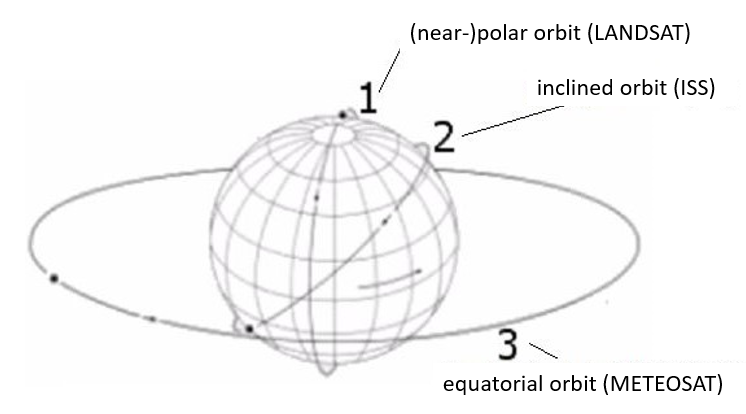

Los satélites meteorológicos suelen ser satélites geoestacionarios en los que la plataforma está situada a una altitud de unos 36.000 km sobre el ecuador y se desplaza con la Tierra a la velocidad de una órbita al día. Debido a la gran distancia a la superficie terrestre, se puede tomar a intervalos cortos una imagen (de resolución comparativamente baja) de todo un hemisferio visible desde el satélite. En las órbitas polares, el satélite orbita la Tierra de polo a polo a unos cientos de kilómetros de altura. Sin embargo, lo más frecuente es que el plano orbital esté ligeramente inclinado con respecto al eje de rotación (órbita casi polar). Las órbitas heliosincrónicas son órbitas casi polares, en las que el satélite pasa sobre cualquier punto de la superficie del planeta a la misma hora local. Esto facilita la comparación de observaciones de procesos en la Tierra realizadas en días diferentes, ya que el ángulo de incidencia del sol y, por tanto, las características de reflexión de la superficie no cambian. Los satélites LANDSAT son un ejemplo destacado de órbitas casi polares sincronizadas con el sol (véase la Figura 2.8).

Desde principios de los años setenta, los satélites de observación de la Tierra (EO; Erth Observation) se han convertido en una herramienta importante también para las Ciencias de la Tierra. A pesar de la baja resolución espacial de los primeros satélites LANDSAT (aproximadamente 80 m) y de los problemas asociados para reconocer e interpretar objetos individuales y fenómenos lineales, las imágenes proporcionadas por el sensor LANDSAT permitieron por primera vez cartografiar zonas de difícil acceso, así como detectar cambios de fenómenos específicos en la superficie terrestre durante periodos de tiempo más largos.

La lista de satélites de teledetección plenamente operativos han crecido desde entonces. Además de las agencias espaciales nacionales e internacionales y los programas de vigilancia del medio ambiente, también los operadores de satélites comerciales tienen una creciente importancia, especialmente para el suministro de datos de teledetección de alta resolución. En la siguiente sección presentamos algunas de las plataformas de satélites más importantes, centrándonos en los satélites con sensores ópticos para aplicaciones en el ámbito espacial.

2.1.4.1 LANDAST

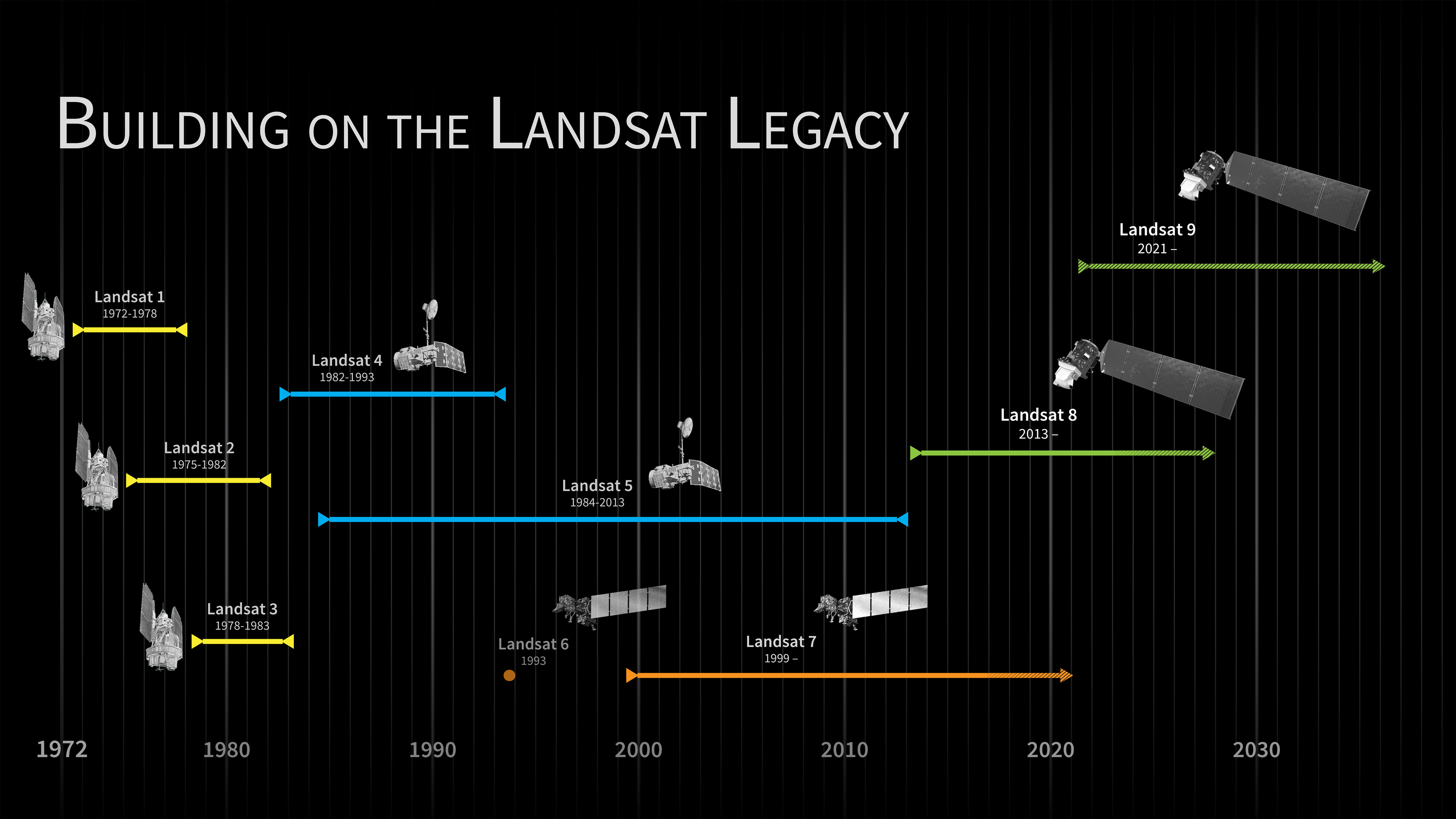

El primer satélite de la misión estadounidense LANDSAT para la observación civil de la Tierra (LANDSAT 1) se lanzó en 1972. Con el suministro de un nuevo sensor con mejor resolución espectral, radiométrica y espacial (30 m) en LANDSAT 4 y 5 (Thematic Mapper - TM), el número de usuarios se disparó. El Thematic Mapper (TM) de LANDSAT 5 proporcionó datos de siete bandas multiespectrales: seis con una resolución espacial de 30 m (azul, verde, rojo, NIR y 2 x MIR), y una banda térmica con una resolución de 120 m. En LANDSAT 7, el Thematic Mapper fue sustituido por el Enhanced Thematic Mapper Plus (ETM+), con la resolución espacial de la banda térmica disminuida a 60 m y un canal pancromático adicional con una resolución espacial de 15 m (Figura 2.9).

En las siguientes misiones de LANDSAT 8 y 9 se mejoró aún más la resolución espectral y radiométrica, y en 2009 todas las escenas de LANDSAT se publicaron gratuitamente, lo que provocó un aumento adicional de usuarios. Especialmente en los paisajes culturales de pequeña estructura, como los que existen en muchas partes de Europa, por ejemplo, la teledetección satelital aportó un considerable valor añadido a los científicos y a los responsables de la toma de decisiones. Actualmente, LANDSAT 8 y LANDSAT 9 orbitan la Tierra a una altitud de 705 km y cada órbita dura unos 100 minutos. En 16 días se registra toda la superficie de la Tierra. Sin embargo, como los dos satélites utilizan la misma órbita con un desfase temporal de 8 días, la tasa de repetición para una zona específica es de sólo 8 días.

Los datos de LANDSAT pueden descargarse gratuitamente desde GloVis, EarthExplorer o a través de LandsatLook Viewer en un plazo de 24 horas desde su recepción. Puede encontrar información reciente sobre el programa LANDSAT en línea aquí.

Debido a los numerosos canales espectrales disponibles (11 bandas en LANDSAT 9), los datos LANDSAT resultan especialmente útiles para la detección del uso/cobertura del suelo (expansión urbana, etc.), en estudios forestales y medioambientales (deforestación de selvas tropicales, etc.), así como para la gestión de recursos (consumo de agua, etc.). Dado que los datos LANDSAT están disponibles para un largo período en el pasado, son especialmente adecuados para estudios espacio-temporales (“detección de cambios”).

2.1.4.2 COPERNICUS

La serie de satélites Sentinel es probablemente el proveedor de datos más importante del programa europeo de observación de la Tierra Copernicus. Mientras que la serie Sentinel-1 consta de satélites radar y Sentinel-3 se utiliza para observaciones oceanográficas, los dos sensores ópticos de Sentinel-2 son especialmente destacables en el contexto de esta lección. Los dos satélites Sentinel de idéntica construcción, Sentinel-2A (lanzado en 2015) y Sentinel-2B (lanzado en 2017), operan en momentos diferentes y permiten así una resolución temporal de 5 días. Con una resolución espacial máxima de 10 metros en el espectro visible, Sentinel-2 supera ampliamente la resolución espacial de los datos LANDSAT 8/9 disponibles gratuitamente. Además, la resolución espectral de Sentinel-2 en el rango infrarrojo de onda corta es significativamente superior a la de los sensores LANDSAT.

Los datos de Sentinel son gratuitos y pueden descargarse a través de Copernicus Open Access Hub.⎄[

Los datos de Sentinel están disponibles en dos niveles de procesamiento diferentes: Nivel 1C y Nivel 2A. Ambos niveles consisten de mosaicos de imágenes de 100 x 100 km corregidos radiométrica y geométricamente (incluida la ortorrectificación). Además, los datos del Nivel-2A también están corregidos atmosféricamente. Además de los datos de imágenes satelitales, el programa Copernicus ofrece varios servicios adicionales. En ellos se comparte más información a un nivel analítico superior, combinada a partir de escenas de imágenes de satélite disponibles y datos in situ (por ejemplo, de estaciones terrestres) (véase la Figura 2.10).

Para más información, consulte este sitio web. Además, la plataforma Earth Online de la ESA ofrece una amplia gama de información sobre las misiones actuales y el acceso a los datos.

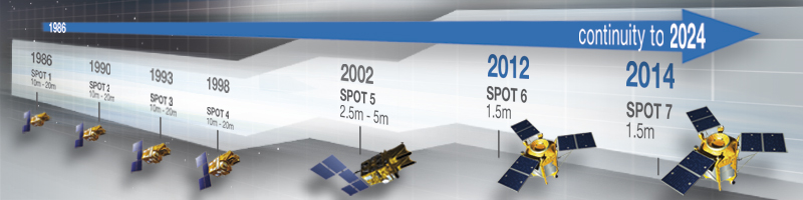

2.1.4.3 SPOT

Durante mucho tiempo, el programa francés SPOT (Système Pour l’Observation de la Terre) fue la única alternativa a LANDSAT para obtener datos de teledetección por satélite óptico de resolución aceptable. El primer satélite francés, SPOT-1, se lanzó en 1986 (véase la Figura 2.11). En la actualidad, SPOT 6 (lanzado en 2012) y SPOT 7 (lanzado en 2014) siguen operativos. Mientras que SPOT 1-4 tenía una resolución pancromática (espacial) de 10 m (¡en 1986 eso era realmente sensacional!), SPOT 5 ya proporcionaba una resolución espacial de 2,5 m, y SPOT 6 y 7 una resolución de 1,5 m (6 m en la gama multiespectral).

Además de la resolución espacial significativamente mayor en comparación con los sensores LANDSAT, SPOT estableció nuevos estándares con otras innovaciones:

Los satélites SPOT pueden programarse para desplazar sus sensores y registrar la misma zona de la superficie terrestre en otra ocasión en la órbita siguiente. De este modo, al disponer de varios satélites SPOT de la misma serie, se puede alcanzar una resolución temporal de (hasta) un día.

El desplazamiento lateral del sensor registra escenas de imágenes desde ángulos ligeramente diferentes. Esto, a su vez, permite derivar Modelos Digitales de Elevación a partir de los datos SPOT.

Estas tecnologías, revolucionarias en su momento, forman parte ahora de los procedimientos habituales, especialmente en las plataformas comerciales de teledetección de alta resolución. Además, el uso de varios satélites idénticos, o al menos comparables, en las llamadas constelaciones de satélites, se ha convertido en un enfoque habitual para aumentar la resolución temporal de las imágenes de satélite. Los satélites SPOT, que ahora opera comercialmente la Airbus Defense and Space, pueden acoplarse además con los satélites Pléiades de alta resolución (operados por la misma empresa) para registrar imágenes de la misma zona varias veces al día.

2.1.4.4 Satélites comerciales de alta resolución

Además de los programas nacionales e internacionales de vigilancia espacial y medioambiental, los operadores comerciales de satélites tienen una importancia creciente, sobre todo en el campo de los datos de teledetección de alta resolución. De hecho, grandes áreas de la fotografía aérea clásica están siendo sustituidas por imágenes de satélite de alta resolución.

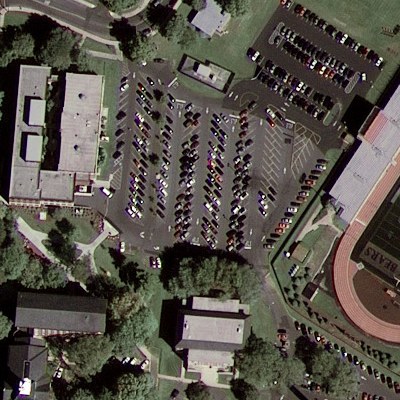

Las aplicaciones que han pasado a formar parte de la vida cotidiana, como los globos digitales, también acceden a datos de imágenes comerciales. Por ejemplo, Google Earth utiliza datos proporcionados por la empresa Maxar, que explota los sensores WorldView y GeoEye, que alcanzan resoluciones del terreno de hasta 0,3 m (pancromáticas) y aproximadamente 1 m (multiespectrales). Estas imágenes de alta resolución tienen múltiples aplicaciones en la planificación urbana, el seguimiento de los flujos de refugiados o la gestión de respuestas de emergencia (terremotos, etc.), por citar algunos ejemplos (véase la fig-highres).

Otro proveedor comercial de datos de teledetección de alta resolución es Planet. Con PlanetScope, esta empresa opera una flota de unos 200 pequeños satélites denominados CubeSats que son baratos de construir y operar pero tienen una corta vida útil. Con este gran número de satélites, PlanetScope puede observar cada punto de la superficie terrestre una vez al día con una resolución espacial de 3,7 m en cuatro bandas multiespectrales en el espectro visible e infrarrojo cercano.

2.1.5 Teledetección con RADAR

La teledetección con RADAR (RAdio Detection And Ranging) difiere considerablemente de los sensores ópticos pasivos que hemos analizado hasta ahora. Los sensores RADAR no registran el reflejo de la luz solar en la superficie terrestre, sino que emiten activamente señales de microondas a la superficie. Los ecos reflejados de la señal son recibidos de nuevo y registrados por el sensor teniendo en cuenta el tiempo de llegada, así como la fase del eco y la intensidad de la señal reflejada. Este vídeo explica el principio de funcionamiento de un sensor de radar basándose en el ejemplo de los pianos voladores.

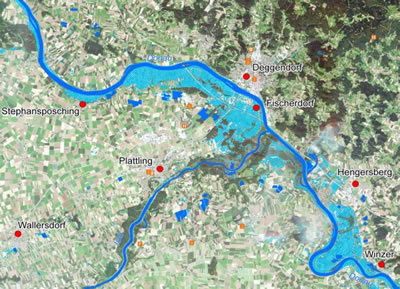

La gran ventaja de los sensores RADAR es que funcionan en todas las condiciones meteorológicas (a diferencia de los sensores ópticos de observación de la Tierra, los haces de radar penetran en las nubes) y no necesitan luz diurna para registrar imágenes. Además, las señales de radar pueden medir la rugosidad de las estructuras de la superficie terrestre hasta centímetros y pueden penetrar en el suelo hasta un máximo de 30 metros en materiales de baja conductividad como la arena seca o el granito. De ahí que la teledetección basada en RADAR tenga un amplio campo de aplicación. Resulta especialmente adecuada para analizar entornos marinos, glaciares o inundaciones (véase la Figura 2.13), puede utilizarse como complemento de los datos ópticos para cartografiar el uso del suelo en zonas de densa nubosidad, así como para crear modelos de elevación mediante interferometría.

Los satélites modernos de radar de apertura sintética (SAR; Synthetic Aperture Radar), como Sentinel-1, pueden programarse para misiones específicas (por ejemplo, la vigilancia de inundaciones) cambiando la alineación de la antena. El alemán DLR opera dos satélites SAR: TerraSAR-X y TanDEM-X. Otro ejemplo es RADARSAT, de la Agencia Espacial Canadiense.

2.2 Análisis de imágenes

En el análisis de imágenes, damos sentido a las imágenes aéreas y de satélite extrayendo información útil de los datos en bruto de las imágenes para su posterior uso en un SIG. Es la etapa central del flujo de trabajo de análisis de datos de teledetección.

La interpretación visual de imágenes suele ser el primer paso para identificar y delimitar objetos en una imagen y extraer conclusiones para análisis posteriores. Dado que hoy en día los datos de teledetección están disponibles casi exclusivamente en formato digital, el análisis posterior suele llevarse a cabo con ayuda del procesamiento digital de imágenes y la clasificación de imágenes. En ellos, los objetos se identifican automáticamente y se extrae información de una imagen sin (o con muy poca) “intervención humana”. En la práctica, sin embargo, los procesos digitales rara vez pueden sustituir por completo a la interpretación visual de las imágenes, sino que más bien complementan y apoyan a la interpretación humana de imágenes.

2.2.1 Interpretación visual

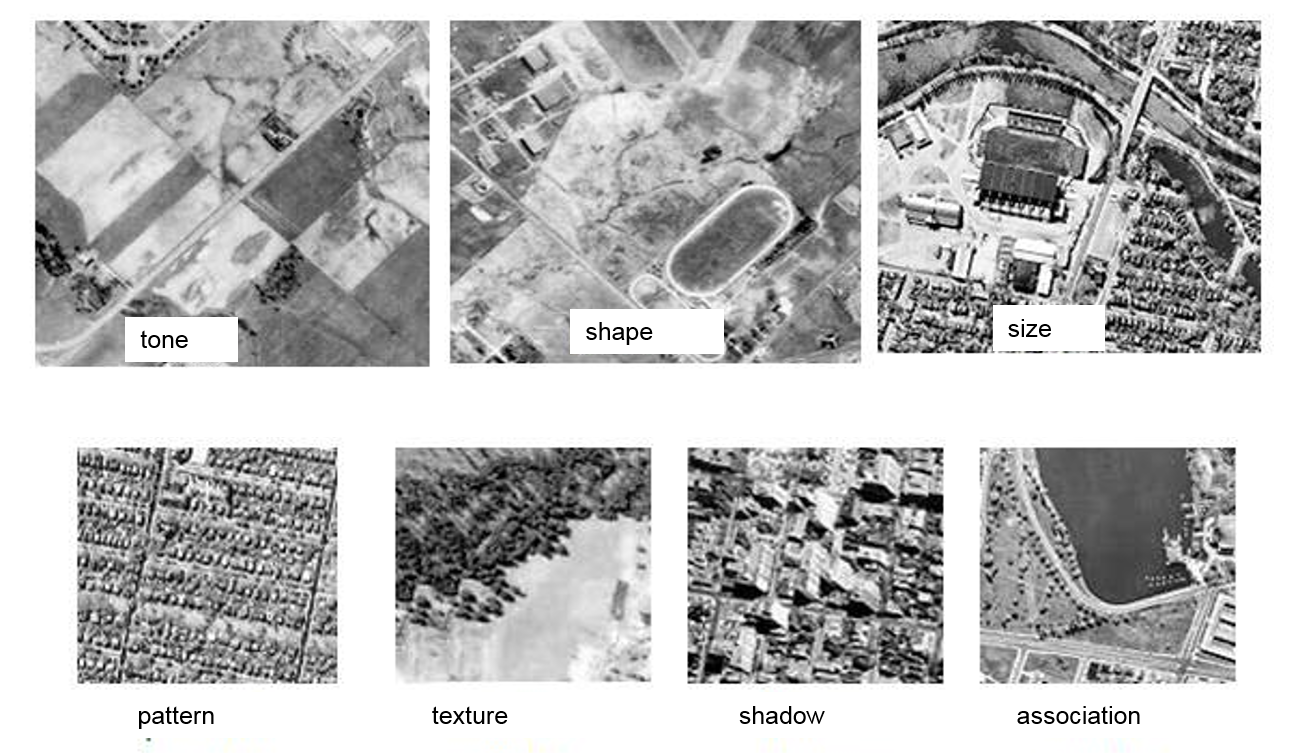

La percepción visual de los objetos desempeña un papel importante en el análisis de imágenes. Sin embargo, esto supone que el intérprete de imágenes tiene algún tipo de conocimiento sobre los objetos que deben analizarse en una imagen. Así, antes de poder procesar la información (temática) inherente a un objeto, hay que describir con precisión su aspecto mediante la definición de los siguientes parámetros visuales del objeto: tono, forma, tamaño, patrón, textura, sombra y contexto (véase la Figura 2.14).

Hue: se refiere al brillo o color relativo de un objeto y depende de las propiedades reflectantes de su superficie. En general, el hue (tono) es el parámetro más importante para identificar visualmente diferentes objetos. Además, las variaciones de color permiten distinguir entre objetos de la misma forma, textura y patrón.

Forma: se refiere a la forma, estructura o contorno de un objeto. En concreto, la forma puede ser útil para identificar correctamente un objeto: Los límites rectos suelen representar el uso del suelo urbano o agrícola, mientras que los elementos naturales, como los bosques, tienden a tener una forma más irregular (a menos que estén delimitados artificialmente por carreteras o desmontes).

Tamaño: el tamaño o extensión espacial de un objeto es función de la escala. Es importante interpretar el tamaño en relación con otros objetos y con el área parcial de una imagen que se analiza. Una estimación rápida y aproximada del tamaño del objeto puede facilitar mucho el análisis de la imagen, por ejemplo a la hora de identificar las clases de uso del suelo. En una zona con una variedad de edificios de distinto tamaño, los edificios grandes, como fábricas o almacenes, tienden a indicar un uso comercial, mientras que los edificios más pequeños podrían indicar un uso residencial.

Patrón: se refiere a la disposición espacial de los objetos que puede distinguirse visualmente. Las texturas o tonalidades recurrentes y regulares dan lugar a patrones de objetos típicos y fáciles de reconocer. Los huertos de prados con una disposición regular de los árboles o los asentamientos de viviendas unifamiliares con calles y casas dispuestas con regularidad son buenos ejemplos de patrones.

Textura: se refiere a la disposición y frecuencia de los valores de brillo cambiantes en zonas parciales de una imagen y es uno de los elementos más importantes para distinguir objetos en las imágenes de radar. Las texturas gruesas parecen “moteadas”, con valores de brillo que cambian bruscamente dentro de un área pequeña. Por el contrario, los valores de brillo de las texturas lisas no varían mucho y son en su mayoría el resultado de superficies planas y uniformes (por ejemplo, masas de agua, asfalto o zonas verdes). Las zonas con una superficie rugosa e irregular, como el dosel de un bosque, tienen una textura gruesa y muy característica.

Sombras: ayudan a interpretar la imagen (hasta cierto punto), ya que proporcionan una idea del relieve y las alturas relativas de los objetos. Sin embargo, también pueden complicar el análisis de una imagen, cuando los objetos se sitúan en zonas de sombra, haciéndolos menos (o nada) distinguibles de su entorno.

Contexto: considera la relación contextual entre distintos objetos de interés. En cuanto al parámetro del “tamaño”, por ejemplo, el uso comercial de una zona suele estar relacionado con la proximidad a vías de transporte importantes (“grandes”), mientras que las zonas residenciales están relacionadas con la proximidad a colegios, parques infantiles o campos de deporte.

2.2.2 Tratamiento digital de imágenes

El tratamiento de imágenes, en general, es la transformación de una imagen de origen en una imagen de salida. En el tratamiento digital de imágenes, esta transformación se realiza con ayuda de funciones matemáticas.

Las técnicas y métodos de tratamiento digital de imágenes pueden clasificarse en: Preprocesamiento, mejora, transformación y clasificación de imágenes.

El preprocesamiento de imágenes incluye todos los pasos que normalmente tienen lugar antes del análisis real de la imagen. Existen dos grandes grupos de técnicas de tratamiento de imágenes:

Las transformaciones geométricas alteran la forma de una imagen, mientras que sus valores de gris (valores de brillo) se conservan, como explicamos en la lección “Imágenes aéreas y fotogrametría”. Como ya hemos oído, estas correcciones geométricas tienen por objeto eliminar las distorsiones de las imágenes (aéreas) debidas a las variaciones de la geometría sensor-tierra y transformarlas en un sistema de referencia espacial adecuado.

Las transformaciones radiométricas alteran los valores de gris de una imagen, al tiempo que preservan sus propiedades geométricas para reducir o eliminar las anomalías que se producen durante la adquisición y transmisión de datos. La mejora radiométrica de las imágenes también incluye mitigar la influencia de la atmósfera en los datos de la imagen mediante la reducción del contraste. Por lo tanto, las transformaciones radiométricas tienen como objetivo convertir los datos de la imagen para que representen con precisión la radiación reflejada de un objeto que fue medida por un sensor.

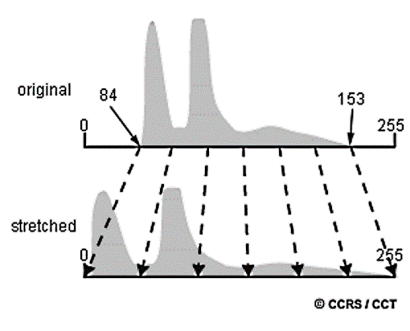

El objetivo de la mejora de imágenes es mejorar el aspecto (visual) de una imagen para su posterior interpretación y análisis, mediante métodos que nos permitan distinguir entre los objetos (o características) de una escena de imagen de forma más sencilla. Esto es especialmente importante para la interpretación visual de imágenes. La mejora del contraste es una herramienta muy potente que altera los valores originales de las imágenes en bruto utilizando toda la gama de valores digitales disponibles (256 niveles de color en el modelo RGB). Utiliza un histograma que representa gráficamente la frecuencia de todos los valores de gris individuales (0-255) en una escena de imagen. En los datos de la imagen original, los valores de gris suelen estar limitados a una determinada gama y muchos de los 256 valores de brillo posibles sólo aparecen raramente o ni siquiera aparecen, lo que reduce considerablemente el contraste de la escena. Por ello, mediante la mejora del contraste, los valores de gris de la escena se transforman en una nueva escena de mayor contraste aplicando un contraste lineal o ecualizado por histograma o un estiramiento del histograma (véase la Figura 2.15).

Otra técnica habitual para mejorar las imágenes es el filtrado digital (espacial). En este, se pueden utilizar operaciones de filtrado específicas, por ejemplo, filtros high-pass o low-pass, para realzar o suavizar los patrones de los objetos en una escena (por ejemplo, afinando los bordes de un objeto o suprimiendo el ruido de la imagen).

Las transformaciones de imágenes son operaciones similares a las de mejora de imágenes. Sin embargo, mientras que las técnicas de mejora de imágenes suelen centrarse en un único canal espectral, las transformaciones de imágenes representan un tratamiento combinado de datos de varias bandas espectrales. Se realizan operaciones aritméticas (restas, sumas, multiplicaciones, divisiones), por ejemplo, para combinar las bandas originales y convertirlas en una “nueva” imagen que destaque características específicas (por ejemplo, la cubierta vegetal) de una escena. Este sitio web ofrece una visión bastante amplia de los canales espectrales, las combinaciones de canales y los índices que se calculan a partir de canales espectrales específicos y sus combinaciones para resaltar diferentes temas, utilizando Sentinel 2 como ejemplo.

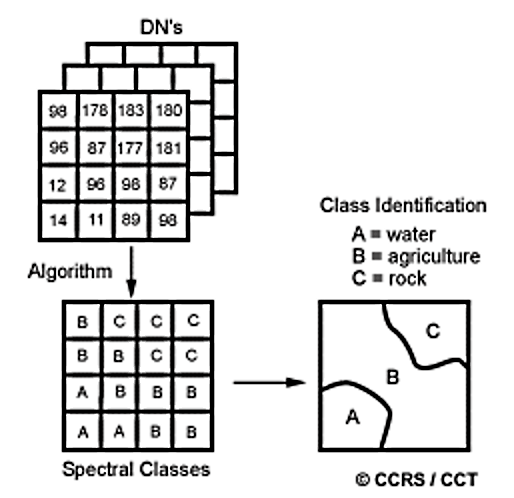

El objetivo general de los procedimientos de clasificación de imágenes es clasificar automáticamente todos los píxeles de una imagen en clases de cobertura del suelo u otras categorías temáticas (Lillesand, Kiefer, y Chipman 2015). Hacen referencia a un grupo importante de métodos que analizamos a continuación.

La clasificación de imágenes es el proceso de extracción de clases de objetos (temáticos) a partir de un conjunto de datos de imágenes multiespectrales.

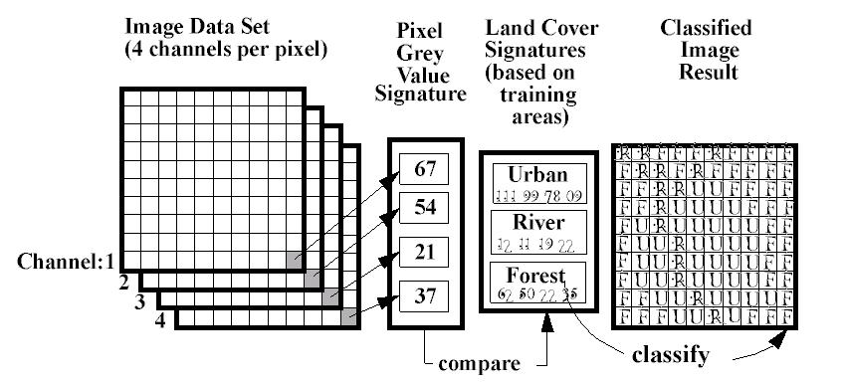

Este enfoque se basa en la idea fundamental de que las diferentes clases de objetos (por ejemplo, agua, bosques, praderas) tienen propiedades espectrales específicas (reflejan, absorben y transmiten proporciones diferentes de energía electromagnética), que se registran en diferentes canales espectrales de un sensor de teledetección. El ráster resultante puede utilizarse para crear mapas temáticos de clases de ocupación o uso del suelo. Mientras que los objetos de una escena de imagen (muy) pequeña pueden detectarse e interpretarse manualmente (por ejemplo, mediante la digitalización de estos objetos en el fondo de la imagen), las técnicas automatizadas de clasificación de imágenes se utilizan para analizar escenas más grandes.

Existen dos métodos principales para clasificar automáticamente imágenes de teledetección: la clasificación basada en píxeles y la clasificación basada en objetos. Independientemente del método utilizado, los resultados de una clasificación deben verificarse siempre mediante una evaluación de la precisión. En ella, se compara la realidad de la superficie terrestre en algunos puntos seleccionados al azar con los resultados de la clasificación de imágenes en la misma posición de la escena de la imagen. Esto también se denomina verdad sobre el terreno (ground truth). En cualquier caso, los parámetros de calidad para las clases de objetos individuales o para toda la escena pueden derivarse de la proporción de clases temáticas asignadas correctamente a los distintos objetos en el proceso de clasificación de imágenes.

2.2.2.1 Clasificación basada en píxeles

En una clasificación basada en píxeles, cada píxel de la escena de la imagen se asigna a una clase temática que se basa en sus valores de reflexión en los canales espectrales del sistema de teledetección. Dentro de la clasificación basada en píxeles, existen dos enfoques: la clasificación supervisada y la clasificación no supervisada.

En una clasificación supervisada, el intérprete de imágenes identifica áreas de entrenamiento homogéneas en la imagen que representan clases temáticas previamente determinadas (por ejemplo, prados, bosques, masas de agua). La selección de las áreas de entrenamiento apropiadas (cada área de entrenamiento debe constar de un mínimo de 50 píxeles) se basa en la familiaridad del analista con la zona geográfica y en el conocimiento de los tipos de cobertura del suelo (en la mayoría de los casos) presentes en la imagen. En un siguiente paso, la información numérica de todas las bandas espectrales de los píxeles que componen un área de entrenamiento se utiliza para entrenar un software que identifique áreas (píxeles) con una firma espectral similar para cada clase temática y, a continuación, asigne cada píxel de la imagen a la clase temática con la firma espectral más similar. Así, en una clasificación supervisada primero identificamos las clases de información (temática) que luego utilizamos para determinar las clases espectrales que representan la información temática. En cualquier caso, este enfoque implica una mayor interacción del intérprete de imágenes (el especialista en SIG) con el software de tratamiento de imágenes que en los métodos de clasificación no supervisada, ya que es necesario seleccionar las áreas de entrenamiento.

Los enfoques más comunes para llevar a cabo una clasificación supervisada son la clasificación de distancia mínima y la clasificación de máxima verosimilitud. En la actualidad, se utilizan cada vez más métodos de clasificación más recientes, como random forests.

Normalmente, hay tres pasos básicos en el flujo de trabajo de una clasificación supervisada, a saber (véase la Figura 2.16):

- Entrenamiento: selección de áreas de entrenamiento dentro de la imagen que se sabe que contienen las clases (temáticas) de interés para la clasificación.

- Clasificación: uso de firmas espectrales para generar información temática basada en las áreas de formación seleccionadas.

- Resultado: creación de mapas o capas digitales que puedan utilizarse en análisis SIG posteriores.

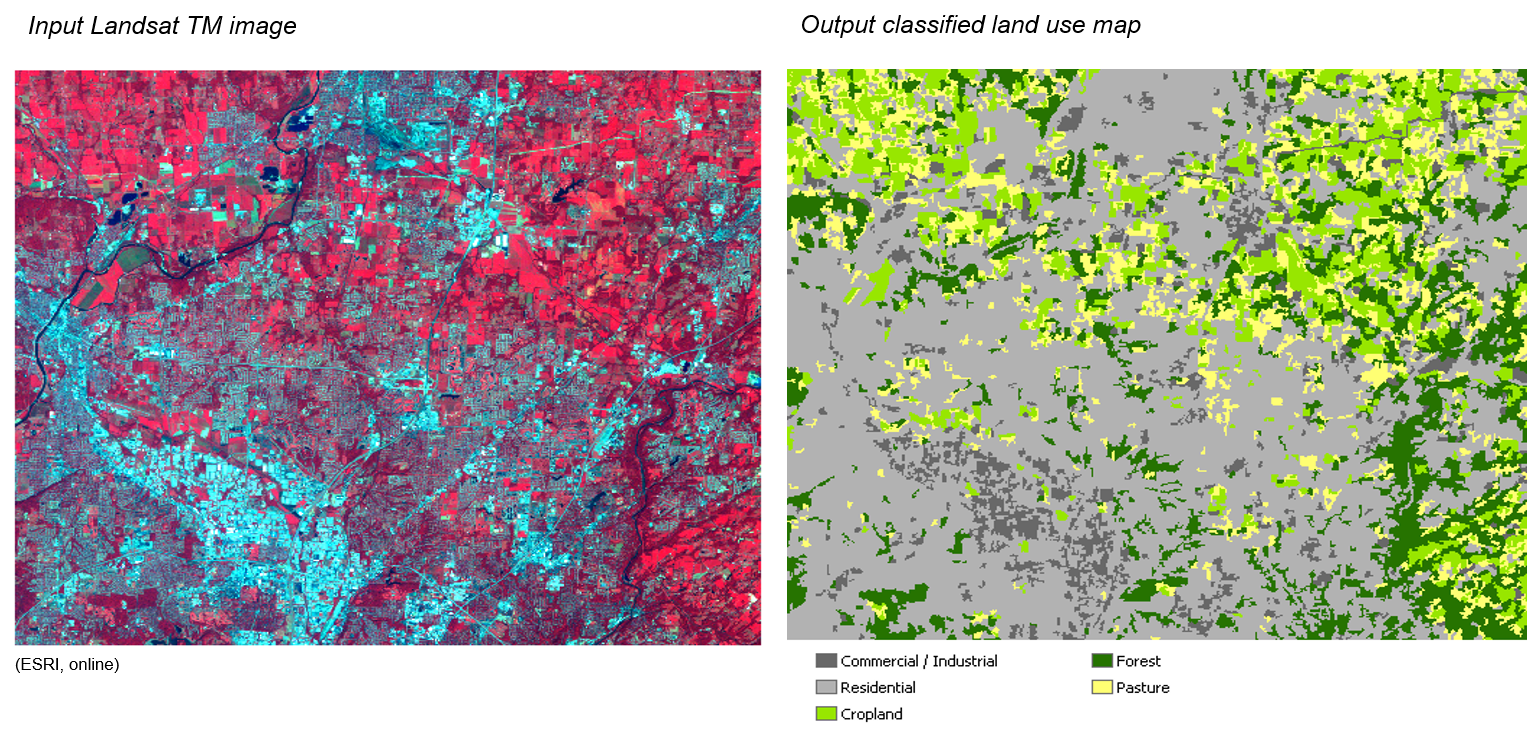

El siguiente ejemplo resume el flujo de trabajo de clasificación supervisada de una imagen de satélite Landsat TM de Cincinnati, OH (véase la Figura 2.17):

- Definición de cinco clases de uso del suelo (comercial/industrial, residencial, tierras de cultivo, bosques y pastos) en la imagen de satélite sin procesar (imagen Landsat TM de cuatro bandas).

- Identificación de las muestras de entrenamiento.

- Realización de una clasificación de máxima verosimilitud para crear el mapa final de uso del suelo.

- Evaluación de la precisión de los resultados de la clasificación.

2.2.2.2 Clasificación no supervisada

En esencia, la clasificación no supervisada invierte el proceso de clasificación supervisada. Primero se agrupan las clases espectrales, basándose únicamente en la información numérica de los datos, y después el intérprete de imágenes las empareja con las clases de información. A continuación, se utilizan los llamados algoritmos de agrupación, como k-means clustering, para determinar las agrupaciones o estructuras naturales (estadísticas) de los datos (véase la Figura 2.18). Normalmente, el intérprete especifica cuántos clusters (clases) deben identificarse en los datos. Además de especificar el número de clases deseado, el intérprete también puede especificar parámetros relacionados con la distancia de separación entre los clusters y la variación dentro de cada cluster. El resultado final de este proceso iterativo de clustering puede dar lugar a algunos clusters que el intérprete desee combinar o descomponer en clusters adicionales en un siguiente paso - cada uno de los cuales requiere una nueva aplicación del algoritmo de clustering. En la práctica, la clasificación no supervisada es menos popular que la supervisada. Sin embargo, se utiliza para obtener información preliminar o datos de validación para otros métodos de clasificación.

2.2.2.3 Clasificación basada en objetos

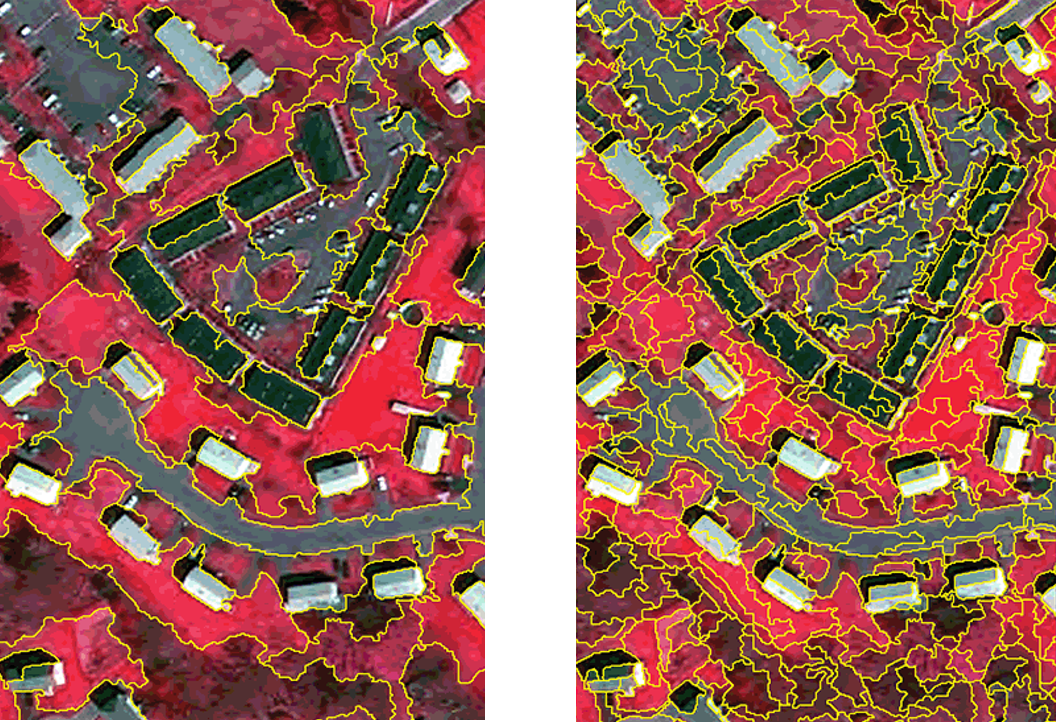

Mientras que las técnicas de clasificación basadas en píxeles utilizan la información espectral de cada píxel, las técnicas de clasificación basadas en objetos (o Análisis de Imágenes Basado en Objetos - OBIA) utilizan tanto los patrones espectrales como espaciales de los objetos de una imagen para un proceso de clasificación en dos pasos (Lillesand, Kiefer, y Chipman 2015) que consiste en:

- Segmentación de una imagen en objetos discretos. Aquí, los píxeles vecinos y similares se combinan para formar objetos. Este proceso de segmentación tiene lugar en distintos niveles de escala (véase la Figura 2.19).

- Clasificación de estos objetos. A partir de los objetos resultantes del proceso de segmentación, se seleccionan objetos de referencia (por ejemplo, el objeto “treetop” que consiste de varios píxeles), de forma similar a como se hace en una clasificación supervisada. Para obtener el resultado final, los objetos restantes se comparan con estos objetos de referencia y, a continuación, se clasifican.

La clasificación basada en objetos desempeña un papel importante, sobre todo cuando se trata de datos de teledetección de alta resolución. El supuesto básico de este enfoque es que la imagen que se clasifica está formada por parches relativamente homogéneos cuyo tamaño es mayor que el de los píxeles individuales. La ventaja de este método significativamente más complejo es que, además de las propiedades espectrales de los objetos de la imagen, también pueden utilizarse como criterios de clasificación otros parámetros como la forma del objeto, la estructura de la superficie o la proximidad a otros objetos.

Este documento proporciona una visión general del tema de OBIA, si usted está más interesado. Además, el área de investigación EO Analytics de Z_GIS se centra en temas aplicados de OBIA, entre otros.

2.2.3 Integración y análisis de datos

En los primeros tiempos de la teledetección (la “era analógica”), la integración de datos procedentes de múltiples fuentes era limitada. Como hoy en día la mayoría de los datos están disponibles en formato digital, la integración de distintos tipos de datos (multitemporales, multiresolución o multisensor) procedentes de distintas fuentes es un método habitual para interpretar y analizar datos (de teledetección).

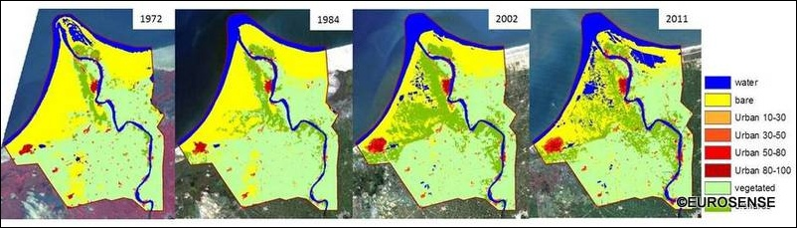

Un ejemplo típico de integración de datos multitemporales es el proceso de detección de cambios que identifica las zonas en las que la cubierta terrestre (o el uso del suelo) ha cambiado entre las distintas fechas de adquisición de las imágenes (véase la Figura 2.20).

Cuando se utilizan datos multitemporales para la detección de cambios, es importante que los datos hayan sido adquiridos por el mismo sensor (o uno similar), con la misma resolución espacial y radiométrica, la misma geometría de imagen, las mismas bandas espectrales y la misma hora del día. Además, y a pesar de tener en cuenta todos estos parámetros, un proceso de detección de cambios puede verse considerablemente influido por diversos factores ambientales (por ejemplo, los efectos atmosféricos).

La integración de datos de teledetección de diferente resolución espacial es importante para diversas aplicaciones. En concreto, para el proceso de nitidez de la imagen (o panorámica) que combina una imagen pancromática de alta resolución espacial con datos de imágenes multiespectrales de menor resolución espacial para obtener una imagen multiespectral de alta resolución (véase la Figura 2.21).

El concepto de fusión de datos multisensor requiere que los datos se registren en un sistema de coordenadas geográficas común. Un ejemplo de fusión de datos multisensor es la integración de datos ópticos multiespectrales e imágenes de radar, o la integración de modelos digitales de elevación (MDE) y datos de teledetección.

En cualquier caso, la integración de distintos tipos de datos procedentes de diferentes fuentes proporciona un beneficio considerable al intérprete de imágenes (o analista SIG), ya que permite extraer información inherente a una imagen pero no visible a primera vista, por ejemplo, integrando información topográfica y datos de imagen. A medida que las aplicaciones y los productos de teledetección se hacen más populares, los programas de SIG más comunes, como ArcGIS o QGIS, han ido integrando herramientas de análisis de imágenes en los últimos años. También existen productos de software específicos de teledetección, como ERDAS Imagine, ENVI o E-Cognition.